| 30/10/2011 |

En el mundo digital siempre encontraremos cosas nuevas y actualizaciones en todos los aspectos.

En esta ocasión quiero comentar una de esas actualizaciones.

En el mundo del video digital, se usan contenedores. Los más populares son el avi, mp4 y mkv. Normalmente se usa mal el término “formato” de video, pues un archivo *.avi, *.mp4 o *.mkv no son formatos de video.

Veamos un ejemplo. Un archivo avi (por ejemplo), puede tener video con codec avc, Divx, Xvid, o incluso sin compresión. También puede tener una o varias pistas de audio con codec mp3, ac3, ogg, wav, etc.

El MP4 soporta más codecs y el mkv más todavía.

Uno de estos codecs, el x264 recientemente hizo una actualización, con la que ahora se pueden crear videos en 10 bits, a diferencia de 8 bits que solía usarse anteriormente. Así que he decidido crear este tutorial para explicar las diferencias entre 8 y 10 bits.

8 o 10 bits. Esa es la pregunta.

Comencemos por el principio. La diferencia entre 10 y 8 bits es la cantidad de colores que se pueden mostrar en un video. Para los matemáticos será sencillo entenderlo, pero intentaré explicarlo un poco más para los que no les gustan las matemáticas xD.

Recordemos que los bits son números binarios. Es decir, sólo pueden existir unos y ceros. La ventaja de este sistema, es que se va duplicando la cantidad (en este caso de colores) con cada bit adicional. En el caso de 8 bits quiere decir que se pueden mostrar un total de 255 variaciones de un mismo color (2x2x2x2x2x2x2x2=256 -1), pero en 10 bits la cantidad de variaciones se dispara hasta 1023 variaciones de un mismo color (2x2x2x2x2x2x2x2x2x2=1024-1). Para los que les surge la duda… sí. Siempre se resta uno, al que se llama bit de control.

Ahora bien, en video digital se usa el sistema RGB (Red, Green, Blue), por lo que si tenemos 256 variaciones por cada color, y mezclamos cada variación de cada color con cada variación de los demás colores tenemos la nada despreciable cantidad de poco más de 16.7 millones de colores (256x256x256 = 16.777.216-1). ¿Y en 10 bits? Tenemos más de 1073 millones de colores (1024x1024x1024 = 1.073.741.824-1). Impresionante ¿no creen? Así que en estos términos, los 8 bits mencionados en realidad son 24 bits, pues son 8 bits por cada color (pueden intentar multiplicando 24 veces 2, y verán que es el mismo resultado).

Ahora bien, las tarjetas gráficas normalmente están configuradas en 32 bits, es decir, más de 4200 millones de colores (4.294.967.295), es decir, 4 veces más que 10 bits.

El origen es muy importante.

Con esa cantidad de colores disponibles muchos pensarían que desde hace mucho tiempo ya se hubiera comenzado a trabajar en 10 bits y con el actual sistema de televisión digital con más razón. Sin embargo, existe un problema.

HDTV (high definition television) es un conjunto de normas para transmitir televisión a través de un alto ancho de banda, se vea en "alta resolución", superior por mucho a las viejas normas análogas NTSC (usado en América) y PAL (usado en Europa).

Dicha norma, al ser digital, se puede medir de varias formas. En mb/s, resolución (normalmente 1280x720 pixeles) o por la profundidad de color, la cual, para sorpresa de algunos y decepción de quienes tengan TV de 10 bits, es precisamente de 8 bits en 3 colores, es decir los mismos 16.7 millones de colores ya nombrados anteriormente.

Si alguien ha visto un televisor a 10 bits, puede decir que se ve mucho mejor que una de 8. Bien, eso es cierto, pero a medias. Resulta que el procesador que trae ese tipo de Tv’s son capaces de convertir de 8 a 10 bits, sin embargo, no es que realmente funcionen con 10 bits. Lo que hace el sistema es, por medio de un complejo proceso matemático “inventarse” los colores que les hace falta para poder mostrar 10 bits.

Ok, pero están los Blu-Ray ¿no?

Es cierto que las grabaciones digitales, como las de las cámaras HD, o los Blu-ray Disk, se graban directamente en un formato digital, por lo que nos evitamos el problema de que la señal pase por ondas de radio (con la consecuente pérdida), por lo que el origen (el Blu-ray Disk o BD para abreviar) y el destino (el monitor o Tv digital) trabajan directamente con datos, así que quizás sería interesante usar los 10 bits en estos casos, pero...

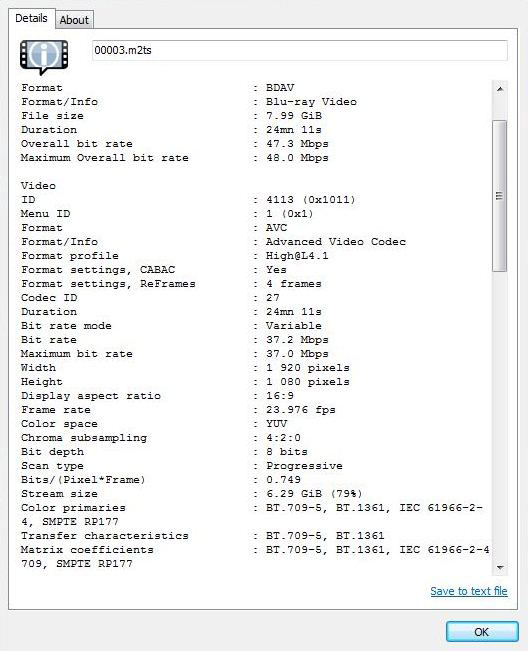

Veamos… aquí dice… Color space: YUV... Chroma subsampling: 4:2:0... Bit depth: 8 bits... a ver, a ver, a ver… ¿cómo es eso?

"Profundidad de color: 8 bits".

Así es… los BD también están grabados en 8 bits… y la biblia dice que un árbol podrido no puede producir fruto excelente.

Así que por mucho macrobloque, banding o filtrado con tweak que haya en pantalla producto de una buena codificación, no tiene mucho sentido hacerlo a 10 bits si nuestra fuente original es de 8 bits.

Supongamos que encuentro una fuente que haya sido grabada de origen a 10 bits ¿Se podría?.

Bien… sí… pero no le veo el caso por al menos 5 razones:

Para empezar, es un hecho indiscutible que un sistema tiene muchísimos más colores que el otro, y el ojo humano es sensible a una enorme cantidad y variación de colores, pero ¿qué tal si el hardware que tengo sólo puede producir 8 bits? Sí, ya sé que antes dije que la tarjeta gráfica de las computadoras trabaja a 32 bits, pero no me refiero a eso, sino al monitor en sí.

Salvo muy contadas excepciones, como los monitores profesionales para fotografía y diseño, todos los monitores siguen siendo de 8 bits, así que realmente no le veo sentido encodear con unos colores que el monitor será incapaz de mostrar.

El segundo problema (aunque este es sencillo de solucionar) es que los codecs para las computadoras necesitan actualizarse, pues si no se hace los videos se reproducirán con mucho macrobloque. Para los que no sepan lo que es el macrobloque, una imagen dice más que mil palabras xD.

Desafortunadamente, la gran mayoría de los usuarios no actualizan ningún programa (si acaso, el antivirus) y esto incluye los codecs, así que a estas alturas ya no me extraña que muchos digan que en 10 bits “se ve muy feo” xD.

El tercer problema son las consolas. Actualmente la Xbox y la PS3 son capaces de reproducir los archivos MP4, el formato más popular actualmente (aunque poco a poco se está cambiando a mkv), pero estas consolas sólo reproducen videos mp4 codificados en 8 bits. Y muchas personas usan las consolas para ver videos.

El cuarto problema es el tiempo de codificación. Se duplica y casi se triplica el tiempo de codificación. Entonces, salvo que tengamos un “mostro” de máquina, el encodeo será eterno (unas 4 o 6 horas por un video de 22 minutos). Entonces, salvo que alguien coopere con un i7 con 16Gb de RAM mínimo, yo seguiré codificandoo a 8 bits xD

El quinto y último problema (más que problema es un tecnicismo) es que yo trabajo con dibujos animados. A diferencia de los videos “normales” con actores, los dibujos animados tienen lo que en el video digital se conoce como “colores duros”.

Los colores duros son colores firmes, que no tienen mucha diferencia en la variación de color entre un pixel y el siguiente, y si hay una diferencia, no es importante, así que en una imagen de dibujos animados hay grandes secciones de la imagen (por ejemplo un rostro o la ropa del personaje) que tienen el color exactamente igual, así que realmente no le veo sentido darle una gran cantidad de colores, cuando usaré muy pocos y repetidos.

¿Sólo son desventajas?

En realidad, sí hay ventajas de encodear a 10 bits.

Volvamos a lo que decíamos que las tarjetas de video están configuradas a 32 bits. Si tenemos en cuenta que los monitores funcionan a 24 bits (8 bits por 3 colores = 24 bits) podríamos pensar que realmente no tiene sentido. Lo cierto es que esto funciona así porque al producir una mayor cantidad de colores, la calidad no se reduce cuando llega al monitor… es como si reprodujéramos un BD (resolución de 1080P) en un televisor normal (480P). Si hacemos esto, no perdemos calidad, pues al reducir la resolución, se queda gran parte de la imagen intacta. Sin embargo hacerlo al contrario sí perdemos calidad… es como poner un viejo VHS en una TV HD de 50” en la que sí sería muy notoria la pérdida de calidad.

Lo mismo pasaría con un video de 10 bits. Aunque el monitor sea incapaz de mostrar todos los colores, sí se notaría una mayor calidad, pues el monitor no pierde calidad al tener un video de entrada de mayor calidad de la que es capaz de mostrar. (Ok, sonó muy redundante xD).

Otra ventaja es que el tamaño del archivo es mucho menor (a veces llega a la mitad).

Resumiendo...

No es que yo esté en contra de codificar videos a 10 bits. Simplemente creo que no es el momento de hacerlo. Pasó lo mismo cuando se empezó a usar el contenedor MP4 en lugar del tradicional AVI. También tardé en hacerlo porque muchas computadoras no lo podían reproducir, o lo hacían con pausas y el hardware que existía en ese momento, como los DVD’s que reproducen DivX, sólo reproducían avi con una resolución máxima de 720X576.

Ahora la cosas es diferente, pues la gran mayoría de las Pc’s, consolas, y reproductores BD ya leen MP4 sin problemas.

Así que cuando los monitores a 10 bits ya se hayan generalizado (aunque ya hay de 12 bits) pensaré de nuevo si vale la pena hacerlo o no. |

|